# Named Entity Recognition via Machine Reading Comprehension: A

https://arxiv.org/abs/2309.11027

# 发表日期

2023 年 9 月

# 作者

Yibo Wang, Wenting Zhao, Yao Wan, Zhongfen Deng, Philip S. Yu

University of Illinois Chicago(伊利诺伊大学芝加哥分校)

# 摘要

命名实体识别任务旨在提取和分类文本中提及的实体到特定的分类(例如组织或者人名)。最近,许多工作已经将命名实体识别任务转为为阅读理解任务。基于上下文,可以通过回答关联类型问题的阅读理解任务来识别命名实体。然而,这些工作忽略了实体类型之间的依赖,而这对命名实体识别任务精确提取至关重要。在本文中,作者主要通过多个 MRC 任务,并通过一个注意力机制串联它们来捕获它们之间的标签依赖。本文在嵌套和扁平化数据集的实验表明本文提取的方法的有效性。实验结果表明该模型在所有实验中均达到了更好的效果。

# 方法

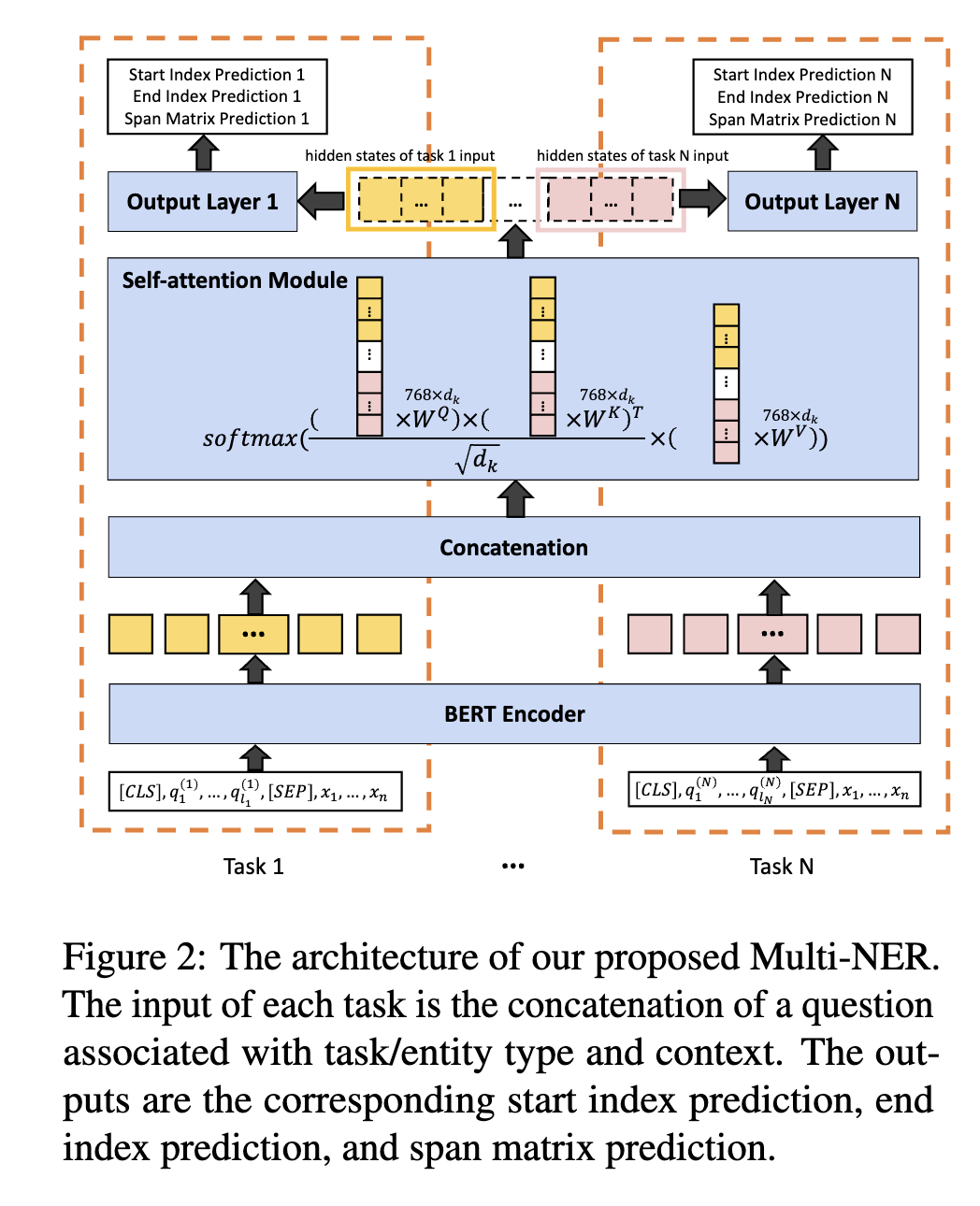

BERT-MRC 定义了三元组(Question,Answer,Context)目标是预测出实体边界和实体类型概率。而本文的模型是在其基础将其拆解为单一标签任务,并且多个任务同时进行。

本文模型相对于 BERT-MRC 多了一个交互模块,这个交互模块将所有的任务联系起来。其损失定义仍然和 BERT-MRC 一致,计算三元组的加权损失:

# 实验

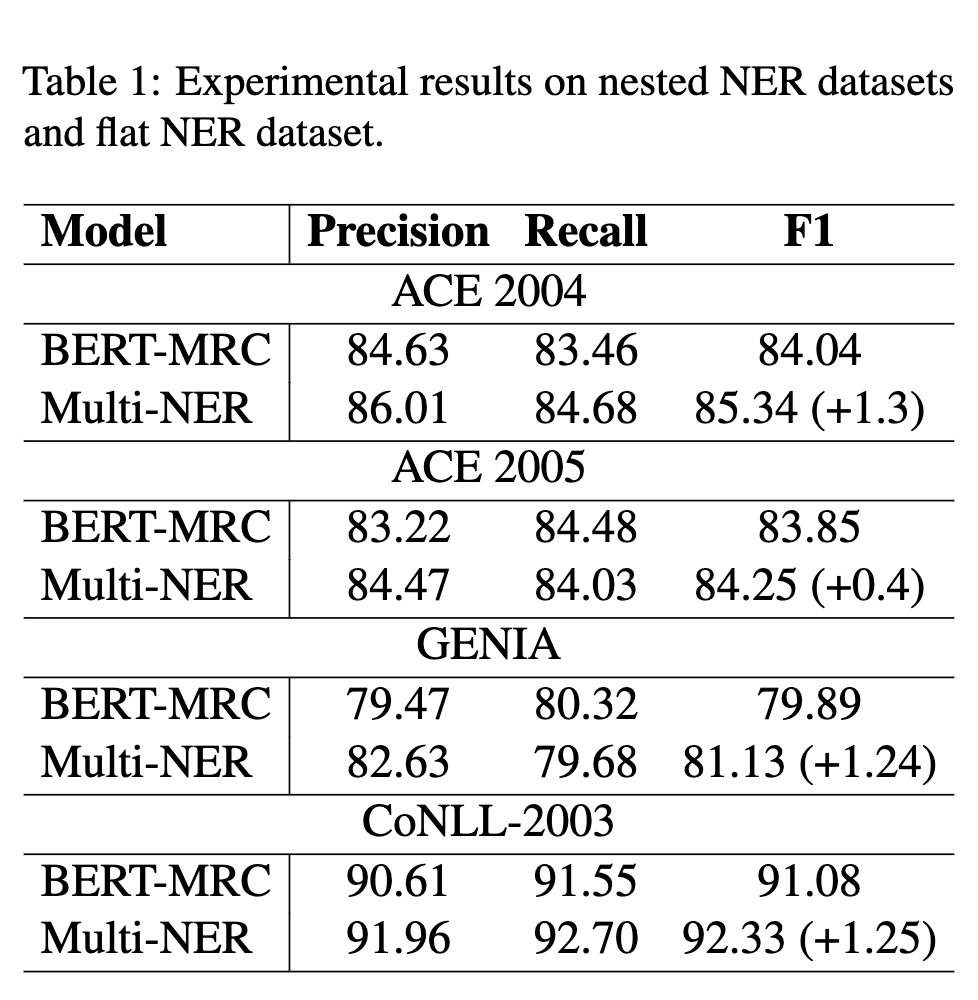

主要对比 BERT-MRC,可以看到大部分数据集都有相应的效果提示。

# 消融实验

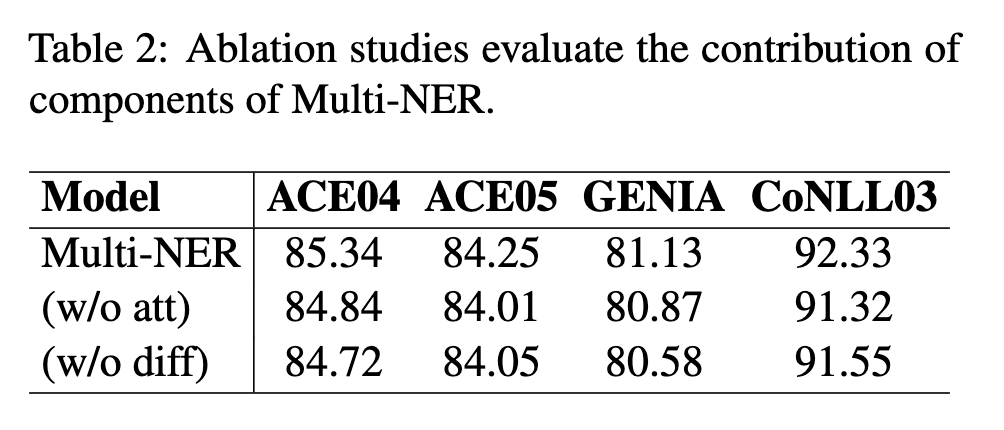

主要针对 Attention 交互以及不同的输出层:

去除模块后均下降了一个点左右,可见模块的有效性。

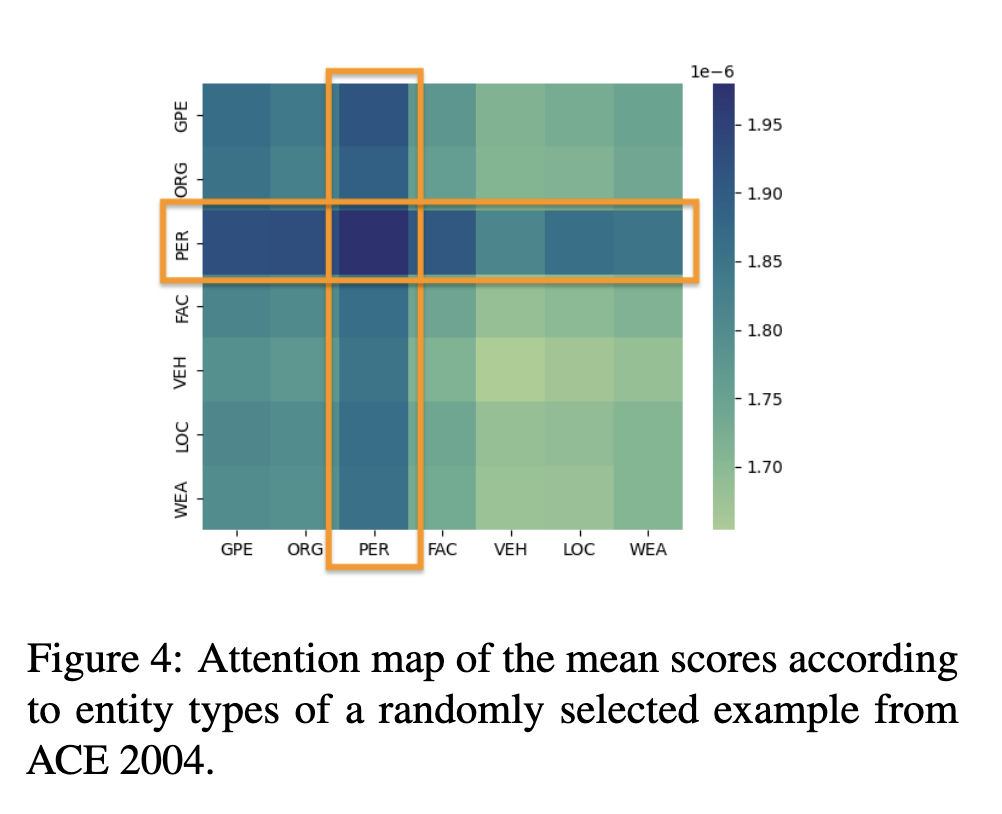

注意力机制分析:

通过输出注意力机制热图,可以发现其注意力权重大部分都在目标标签上,意味着其可以更佳有效的帮助模型区分该实体和其他实体。